前言

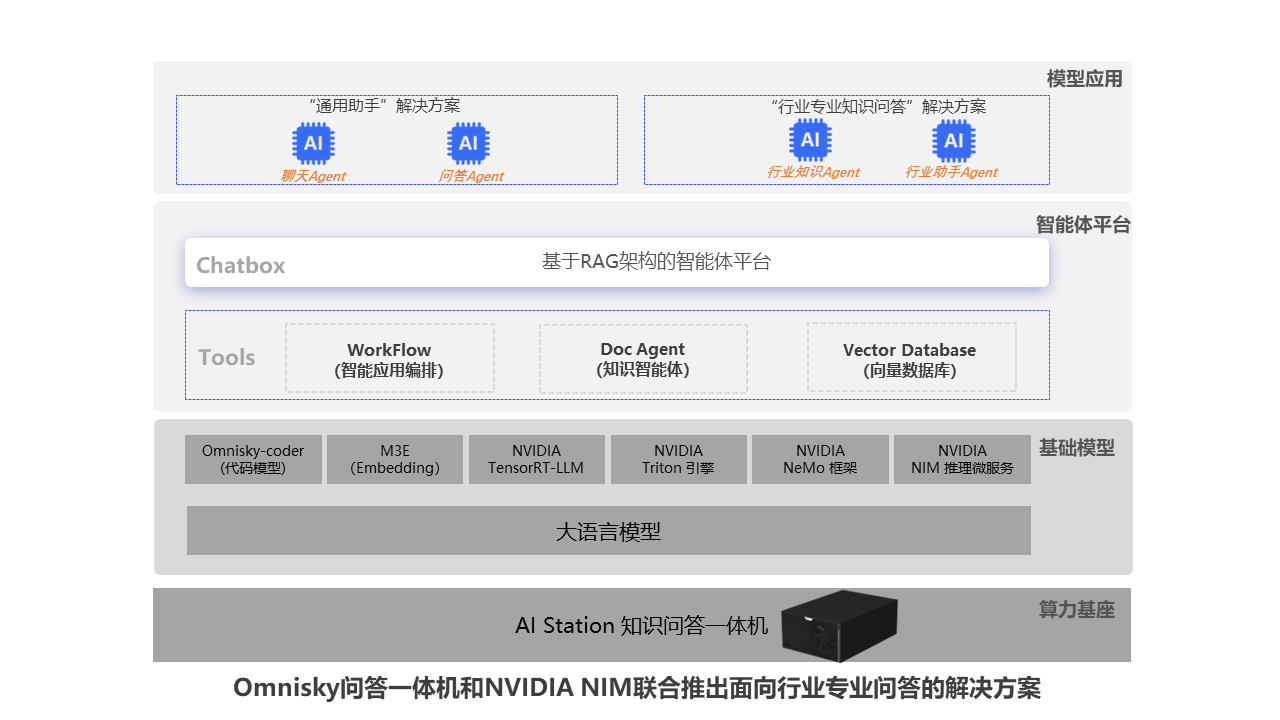

在人工智能领域飞速发展的今天,AI技术被广泛用于多种场景,各个垂直领域都开始应用。在这个背景下,针对垂直领域的行业专业问答尤为重要。NVIDIA NIM(NVIDIA Inference Microservices)推理微服务与Omnisky知识问答一体机联合推出了面向行业专业问答的解决方案,为各垂直领域提供了专业路径。

Omnisky知识问答一体机结合NVIDIA NIM,提供高密度算力和高效推理,实现快速精准的垂直领域行业内专业知识问答。NIM优化AI模型部署,支持多模式生成式AI,确保全球可用性和性能。为追求高效率的团队提供强大支持。Omnisky知识问答一体机的开箱即用特性和NIM的模型部署优化,共同提升了行业应用的效率和性能,使得专业知识问答更加智能化和便捷化。

NVIDIA NIM——模型部署革命

什么是NVIDIA NIM

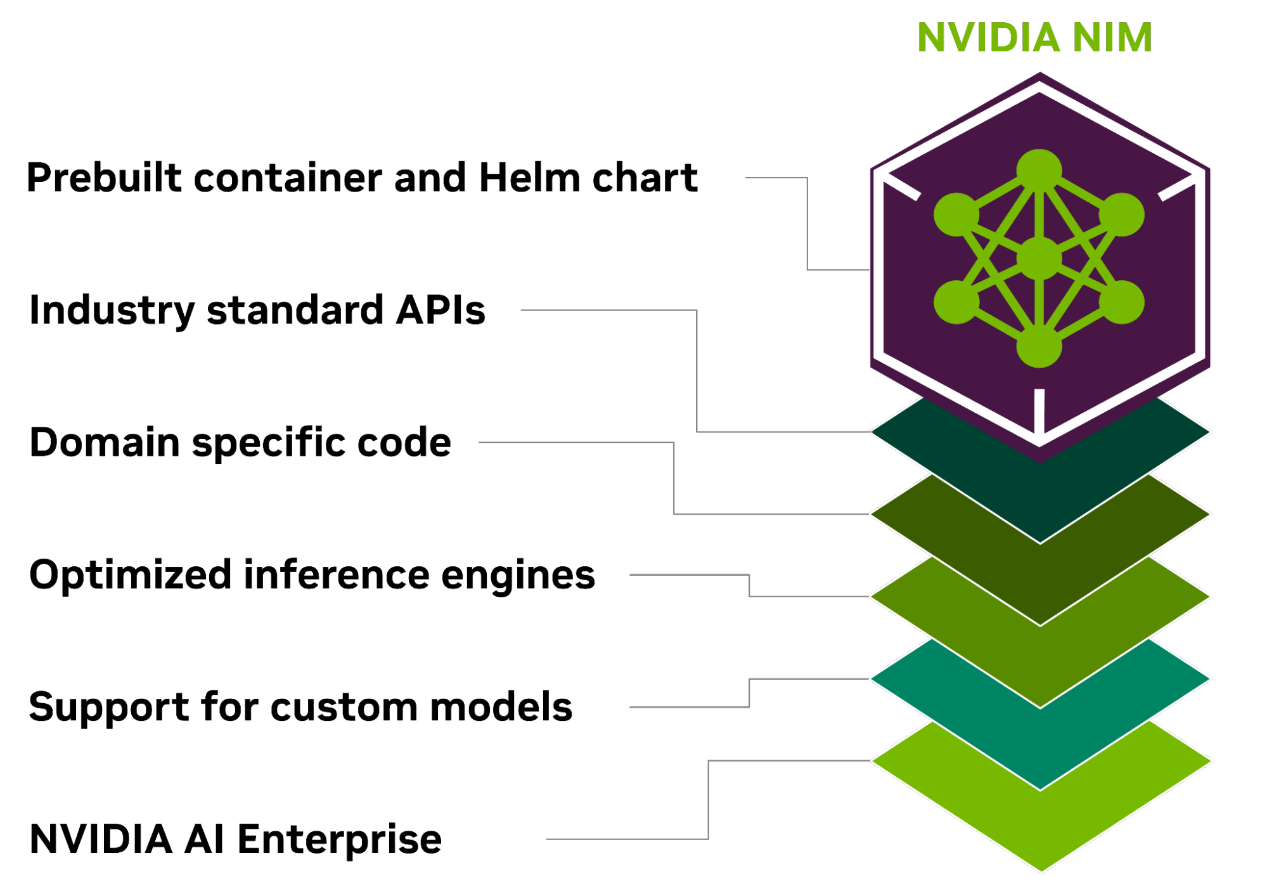

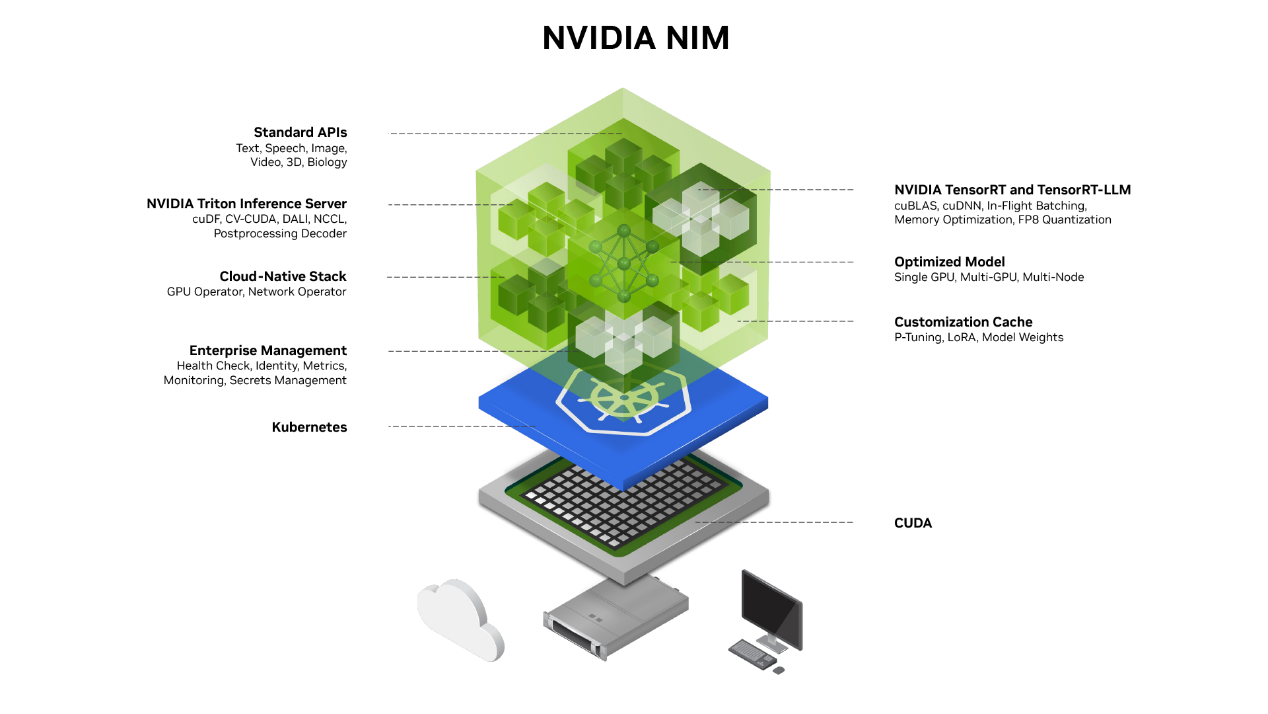

NVIDIA NIM (NVIDIA Inference Microservices)是 NVIDIA AI Enterprise 的一部分,是一套易于使用的预构建容器工具,属于一种推理微服务,目的是帮助企业加速生成式AI的部署。这些预构建的容器支持广泛的 AI 模型。NIM 微服务只需一个命令即可帮助企业客户部署AI模型,以便使用标准 API 和几行代码轻松集成到企业级 AI 应用程序中。

NIM 基于可靠的基础 (包括 Triton 推理服务器、TensorRT、TensorRT-LLM 和 PyTorch 等推理引擎) 构建,旨在促进企业客户根据其自身需求和选择大规模无缝 进行AI 推理,从而确保企业可以满怀信心地在任何地方部署 AI 应用程序。无论是在本地还是在云端,NIM 都能高效实现大规模加速生成式 AI 推理。

为什么使用NVIDIA NIM进行开发

简化开发流程

通过使用NVIDIA NIM,开发者可以大幅度简化开发流程。NIM提供了热门大型语言模型 (LLM) 开发框架中的行业标准API和库,使开发者能够轻松将AI应用集成到应用中。此外,开发过程对于门槛要求低,即使是入门者也可以随心所欲构建自己的应用。

可随时随地部署

NIM 专为可移植性和可控性而构建,支持跨各种基础设施 (从本地工作站到云再到本地数据中心) 进行模型部署。其中包括 NVIDIA DGX、 NVIDIA DGX 云、 NVIDIA 认证系统、 NVIDIA RTX 工作站和 PC。

预构建的容器和 Helm Chart 打包了优化模型,并在不同的 NVIDIA 硬件平台、云服务提供商和 Kubernetes 发行版中进行了严格验证和基准测试。这支持所有 NVIDIA 驱动的环境,并确保组织可以在任何地方部署其生成式 AI 应用,同时保持对其应用及其处理的数据的全面控制,维护生成式 AI 应用程序和数据的安全性和控制权。

基于行业标准 API 进行开发

开发者可以通过符合每个领域行业标准的 API 访问 AI 模型,从而简化AI 应用的开发。这些 API 与生态系统中的标准部署流程兼容,使开发者能够快速更新其 AI 应用 (通常只需 3 行代码)。这种无缝集成和易用性有助于在企业环境中快速部署和扩展 AI 解决方案。

模型可针对特定行业领域

NIM 通过几个关键功能满足了对特定领域解决方案和优化性能的需求。它包含特定于领域的NVIDIA CUDA 库,以及为语言、语音、视频处理、医疗健康等各个领域量身定制的专用代码。这种方法可确保应用程序准确无误并与其特定用例相关。

优化的推理引擎

NIM 针对每个模型和硬件设置,基于经过优化的推理引擎,包括 TensorRT、TensorRT-LLM 和 Triton 推理服务器等,在加速基础设施上提供尽可能好的延迟和吞吐量。有效降低了在扩展推理工作负载时运行推理工作负载的成本,并改善了最终用户体验。除了支持优化的社区模型外,开发者还可以基于从未离开数据中心边界的专有数据源对模型进行对齐和微调,从而实现更高的准确性和性能。

支持企业生产环境 AI

作为 NVIDIA AI Enterprise 的一部分,NIM 采用企业级基础容器构建,通过功能分支、严格的验证、通过服务级别协议提供的企业级支持以及针对 CVE 的定期安全更新,为企业 AI 软件提供坚实的基础。全面的支持结构和优化功能突出了 NIM 作为在生产环境中部署高效、可扩展和定制的 AI 应用的关键工具的作用。

Omnisky知识问答一体机——AI新纪元

Omnisky知识问答一体机介绍

Omnisky知识问答一体机是专为知识问答设计的高端一体化人工智能算力基座,实现精准响应用户知识问答需求。通过精密的工程实现低噪音运行,与办公室和研究环境的高雅氛围无缝融合。搭载NVIDIA算力高密度芯片GPU,结合NVIDIA推理框架及加速模块,以高性价比的方式,支持从基础机器学习到高级算法研究的广泛计算需求,并覆盖AI验证至AI4S的各个领域。其即开即用的特性,辅以优化的软件生态系统,使研究人员和开发者能立即投入创新,同时保持工作环境的专注与和谐。Omnisky知识问答一体机是高性能与易用性典范,专为追求效率与环境协调性的专业团队量身打造,是创新路上的理想伙伴。

Omnisky知识问答一体机的特点

独立部署 开箱即用

Omnisky知识问答一体机设计为独立部署方案,无需依赖外部互联网连接,即便在封闭的内网环境中也能顺畅运行。这一部署模式的核心优势在于其高度的数据隔离性,确保内部信息的安全,防止数据泄露至公共网络,信息交流严格限定在局域网内部。此外,Omnisky知识问答一体机秉承了开箱即用的设计理念,能够在部署完成后迅速启动并投入使用,配置时间成本消耗少。使用NVIDIA NIM还可进一步缩短部署所花时间,更进一步的贯彻开箱即用理念。

极致算力 极高能效

Omnisky知识问答一体机高效集成了2块NVIDIA 智算芯片,保证极致性能的同时采用先进的降噪技术,确保噪音不超过环境音量,专为专注工作设计。同时一体机体型小巧,可放置于办公桌上作为桌边机使用,且能耗接近家用级别,极大缓解用电负荷压力。

全面覆盖 高效推理

Omnisky知识问答一体机基于NVIDIA Triton的高效推理引擎,结合了NVIDIA NIM的推理微服务,达成了卓越性能,确保复杂问题得到迅速且准确的解决。可兼容多领域大模型,支持的模型参数量上限可达千亿级别,具备处理广泛任务时的强劲实力。

平台集成 行业契合

Omnisky知识问答一体机集成了基于RAG(检索增强生成)技术的智能一体化人工智能解决方案平台,可满足通用场景和不同垂直领域的行业专业场景需求,实现开箱即用型推理大模型,专为追求卓越交互体验而构建。平台提供外置知识库与工作流编排能力,深耕行业纵深领域,在知识问答领域设立了效能新高度,答案的准确性和响应时间均展现出超越市场同级产品的性能,同时允许用户通过工作流定制开发行业内智能应用,契合行业专业场景。

NVIDIA NIM和Omnisky知识问答一体机联合优势

NVIDIA NIM与Omnisky知识问答一体机的结合共同构建了一个强大的桌边式AI应用平台,为行业专业问答提供了强大的解决方案。容天知识问答一体机的高密度智算芯片与NVIDIA NIM的算力引擎相结合,可构建一套高吞吐,低延迟的行业专业问答系统。NIM简化开发,可快速部署的特性与Omnisky知识问答一体机轻便,独立部署,开箱即用的能力结合,为用户提供一个易于开发部署,快速落地使用的解决方案;NIM的行业标准 API,针对特定领域的模型优化和对企业生产环境的支持与Omnisky知识问答一体机智能平台的RAG,专业知识库和工作流定制能力结合,供紧密贴合行业专业需求的问答服务。在解决垂直领域的具体挑战方面表现出色,展现了精准的行业洞察和技术专长。

NVIDIA NIM与Omnisky知识问答一体机的结合,为行业专业问答提供了一个易开发部署,扎根纵深领域的解决方案。