将 NVIDIA AI 引入任何服务器的入门级 GPU

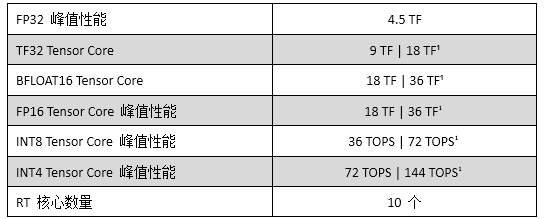

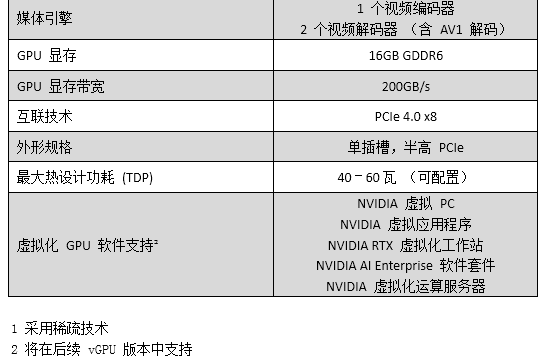

NVIDIA A2 Tensor Core GPU 采用 Ampere 架构,单槽半高半长规格,1280 个 CUDA 核心。配备了 16GB 容量的 GDDR6 显存,位宽为 128 位,速率为 12.5 Gbps,带宽为 200 GB/秒。其 TDP 为 40W 至 60W,不需要外接供电,被动散热结构。

NVIDIA A2 Tensor Core GPU 的基本频率为 1440 MHz,加速频率为 1770 MHz,可提供 4.5 TFLOPS 的单精度计算能力。

由于没有视频输出接口,若不是通过虚拟机环境使用,不能用于游戏。单槽半高半长的规格,旨在用于看重成本效益且需要高度兼容性的服务器中,针对 AI 推理工作负载进行优化。

多用途的入门级推理

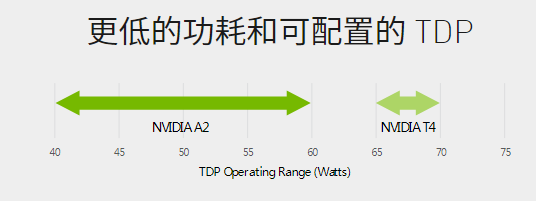

NVIDIA A2 Tensor Core GPU 具有低功耗、小尺寸和高性能的特点,可为在边缘部署 NVIDIA AI 的智能视频分析(IVA)提供入门级推理功能。半高 PCIe 4.0 卡的设计, 40-60 瓦的低热设计功耗(TDP)配置功能,能为大规模部署中的不同服务器带来通用的推理加速能力。

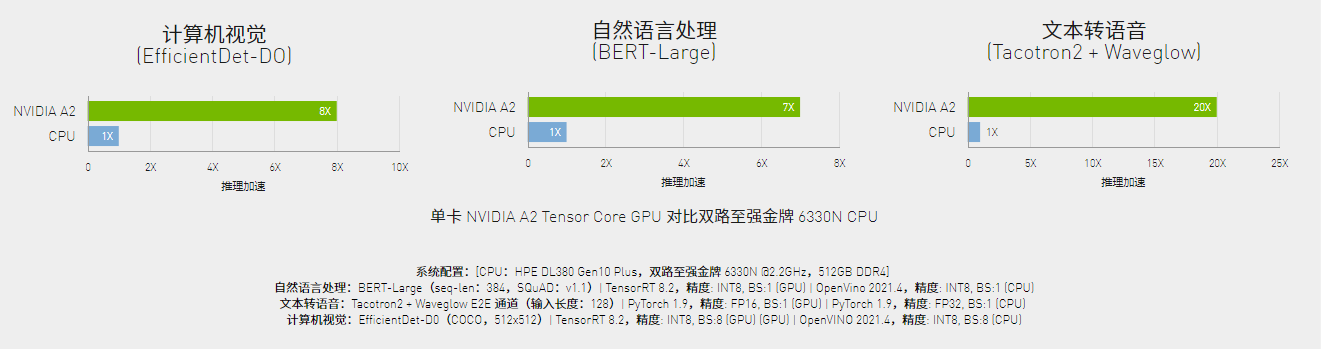

推理性能提升高达 20 倍

与 CPU 服务器相比,配备 NVIDIA A2 Tensor Core GPU 的边缘和入门级服务器可提供高达 20 倍的推理性能,将服务器升级到能处理现代 AI 的水平,为消费者打造更便利的生活。

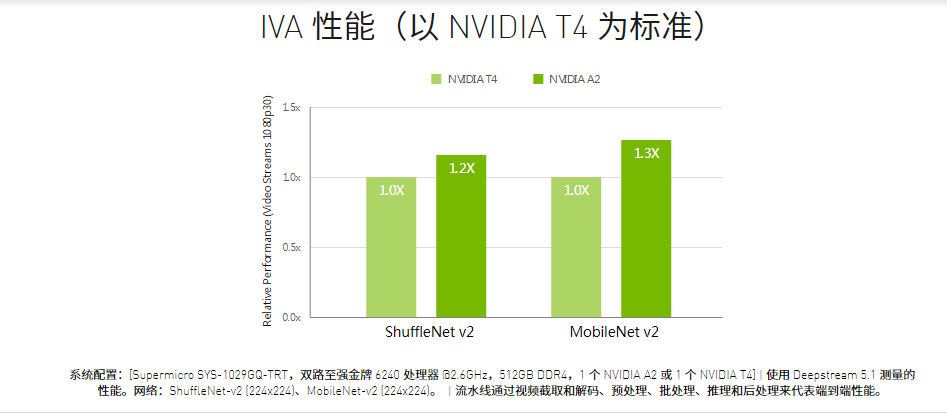

在智能边缘,实现更高的 IVA 性能

在智慧城市、制造和零售等智能边缘用例中,装备 NVIDIA A2 Tensor Core GPU 的服务器最高可将性能提升 1.3 倍。与前几代 GPU 相比,运行 IVA 工作负载的 NVIDIA A2 Tensor Core GPU 最高可将性价比和能效分别提升 1.6 倍和 10%,从而改善部署效率。

针对服务器进行优化

针对 5G 边缘和工业环境这样空间和散热要求受限制的入门级服务器,NVIDIA A2 Tensor Core GPU 为其推理工作负载和部署进行了优化。NVIDIA A2 Tensor Core GPU 提供了在低功耗范围内运行的半高外形,从 60 瓦到 40 瓦的 TDP,使其成为众多服务器的理想选择。

领先的跨云、数据中心和边缘的 AI 推理性能

AI 推理继续推动跨行业的突破性创新,包括消费互联网、医疗保健和生命科学、金融服务、零售、制造和超级计算。NVIDIA A2 Tensor Core GPU 的小巧尺寸和低功耗,可提供跨云、数据中心和边缘的完整AI推理产品组合。更少的服务器、更少的功率、大幅降低成本、更快的洞察力。

支持 NVIDIA AI ENTERPRISE 和认证系统

NVIDIA AI Enterprise 一套端到端云原生 AI 和数据分析软件,经认证可在基于服务器虚拟化平台的虚拟基础设施(带有 VMware vSphere)中的 NVIDIA A2 Tensor Core GPU 上运行。这允许在混合云环境中管理和扩展 AI 和推理工作负载。

搭载 NVIDIA A2 Tensor Core GPU 的 NVIDIA 认证系统™ 将计算加速功能与高速、安全的 NVIDIA 网络整合到 NVIDIA 的 OEM 合作伙伴构建和销售的企业数据中心服务器中。利用此计划,客户可以在单个高性能、经济高效且可扩展的基础设施上识别、获取和部署系统,以运行 NVIDIA NGC™ (NVIDIA GPU CLOUD)目录中的传统和多样化的现代 AI 应用程序。

技术规格

*与 NVIDIA 产品相关的图片或视频(完整或部分)的版权均归 NVIDIA Corporation 所有。